TL;DR: La capacità di alimentare le AI con grandi corpi di conoscenza è un game-changer che promette di ridurre le allucinazioni e permettere l’automazione di molti più processi. I leader delle operations dovrebbero iniziare a porre alle loro squadre domande critiche sulla documentazione, i repository di conoscenza e il design dei processi.

Qualche giorno fa, OpenAI ha rilasciato un importante aggiornamento a un’offerta meno conosciuta, ovvero la sua API “Assistant”. Questo è significativo.

In poche parole, gli Assistants (chiamati anche “Agents” in alcuni link, un fatto interessante), sono istanze di GPT che possono chiamare servizi esterni e attingere da corpi di conoscenza caricabili quando conversano con gli utenti. OpenAI ha massicciamente espanso la dimensione possibile di queste librerie, passando da 20 documenti a 10.000.

Perché è importante?

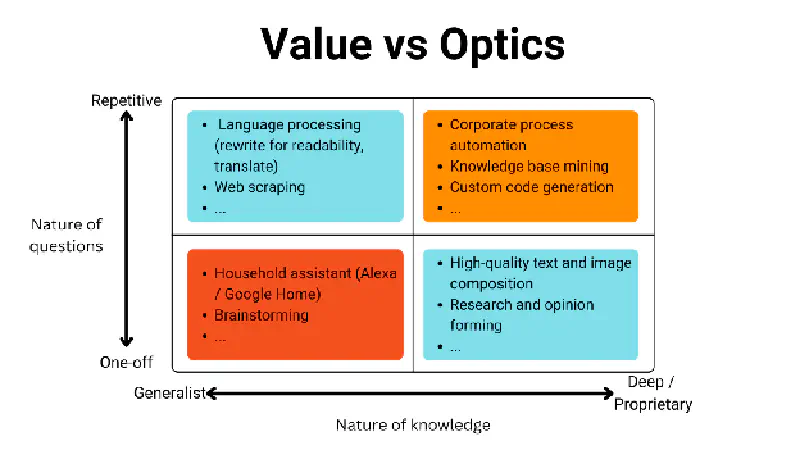

Pensiamo a cosa genera entusiasmo mediatico nell’AI, rispetto a cosa crea valore scalabile. Ecco un framework che potrebbe essere utile (è una matrice 2x2, perché una volta consulente, sempre consulente).

Ciò che genera clamore e controversia è spesso ciò che sta nella riga in basso. Cosa è più intrigante per un giornale da riportare—un’azienda che usa l’AI per organizzare e catalogare note spese; tecnologia che genera volti realistici; o le difficoltà di un giornalista che tenta di usare un assistente virtuale?

Tuttavia, la maggior parte del valore creato dall’AI sarà in lavori radicati nel quadrante in alto a destra di questa matrice 2x2. Questi sono processi ripetibili, dove:

- Le metriche di qualità possono essere sviluppate e monitorate;

- I compiti possono essere isolati e definiti; e dove

- è più facile per i dirigenti costruire un business case per investimenti in efficienza e scalabilità.

Criticamente, questi sono anche processi dove è richiesta conoscenza specifica, spesso confidenziale, e la correttezza fattuale è fondamentale. E sappiamo che la correttezza fattuale non è esattamente il punto di forza di un LLM come le persone stanno scoprendo volta dopo volta.

Entra in scena RAG

… ovvero “Retrieval Augmented Generation”. Questa è una versione della tecnologia che alimenta perplexity.ai, un unicorno che si concentra sul fornire risposte accurate alle domande degli utenti, basandosi su fonti che trova sul web (e no, non è quello che fa ChatGPT da solo).

RAG si basa su un’idea semplice: data una libreria di conoscenza, usa la tua AI per identificare rapidamente le parti rilevanti (molte tecniche lo fanno efficientemente, come la codifica vettoriale e le ricerche per parole chiave, ma questo è un discorso per un altro giorno); poi usa il motore LLM per informare le risposte, abbassando significativamente il tasso di allucinazioni. Essenzialmente, è come un esame a libro aperto rispetto a uno a libro chiuso.

Ed è per questo che la nuova funzionalità di OpenAI è un game-changer. Fino ad ora, gli assistenti GPT (cioè versioni personalizzate e proprietarie di ChatGPT) potevano accedere solo a 20 documenti contemporaneamente. D’ora in poi, il limite è stato alzato a 10.000 documenti alla volta.

Quindi, ora la tua azienda potrebbe caricare le policy HR in un GPT e usarlo per aiutare con la validazione delle note spese. Oppure, potresti caricare materiali di marketing passati, specifiche di prodotto e ricerche di mercato, e usare un GPT personalizzato per criticare o generare bozze di copy marketing. Ricordo i giorni in cui supervisionavo il processo PRC in una startup biotech—non sarebbe stato bello avere un sistema che facesse un primo tentativo di validare se la nostra etichetta supportava ogni claim?

Dovremmo aspettarci una lunga ondata di “automazione nascosta”. Mentre leggi questo, i tuoi concorrenti stanno pensando a modi per condividere la loro conoscenza istituzionale con le AI, per automatizzare o supportare compiti ripetitivi di back-office. I guadagni di produttività saranno enormi e diffusi.

La migliore analogia che mi viene in mente sono le macchine CNC. Non sostituiscono ogni fase di ogni processo manifatturiero; al contrario, i processi vengono spesso ricostruiti intorno ad esse.

Quindi cosa dovremmo fare?

Inizia ponendo domande critiche sulla tua conoscenza e i tuoi processi.

-

Come è organizzata e conservata la conoscenza istituzionale nella tua azienda? Non pensare solo ai manuali di processo: thread email, messaggi Slack—tutto questo si somma a descrizioni di come funzionano i processi. Le AI possono gestire documenti formali e informali.

-

Che tipo di errori puoi tollerare nei tuoi processi? Non dire “nessuno”. Gli esseri umani commettono errori continuamente: organizziamo il lavoro in modo da intercettare (la maggior parte di) essi. Assumiamo persone perché, nonostante la loro fallibilità, aiutano. Lo stesso vale per l’AI.

-

Come puoi progettare i tuoi processi per una migliore automazione? Pensa in modo ampio: le AI non hanno bisogno di moduli come input. Email, testo libero, ecc.—questi possono essere input perfettamente accettabili per un LLM.

-

Come definirai e misurerai il successo? I team di leadership chiedono più efficienza—come puoi dimostrarla? Quali metriche concrete vorresti migliorare?

PS: Sì, Big Tech sta investendo pesantemente nello sviluppo di assistenti personali e chatbot orientati ai consumatori—ma questo sembra essere mirato a guidare l’utilizzo di altri strumenti dell’ecosistema, non a offrire un prodotto autonomo e profittevole.

Pubblicato originariamente su LinkedIn nell’aprile 2024.